На передових технологіях еволюція штучного інтелекту (ШІ) продовжує стимулювати надзвичайні інновації. Але водночас він розгортає наратив, пронизаний побоюваннями щодо вимирання людства. Візіонери штучного інтелекту, такі як Сем Альтман, керівник OpenAI, і Джеффрі Хінтон, загальновизнаний «хрещений батько» ШІ, чітко сформулювали цей страх.

Розкриваючи потенційну катастрофу, відкритий лист від Центру безпеки штучного інтелекту, який підтримали понад 300 шановних підписантів, висвітлив загрозу існування, яку представляє штучний інтелект. Однак те, як це рукотворне диво могло призвести до загибелі людства, залишається дещо загадковим.

ШІ становить загрозу вимирання людства

За словами Дена Хендрікса, директора Центру безпеки штучного інтелекту, штучний інтелект міг би створити безліч шляхів для боротьби з ризиками суспільного масштабу. Одним із таких сценаріїв є зловживання ШІ зловмисними суб’єктами.

«Існує дуже поширена помилкова думка, навіть серед спільноти штучного інтелекту, що існує лише жменька домерів. Але насправді багато людей в приватному порядку висловили б занепокоєння з приводу цих речей», – сказав Хендрікс.

Уявіть собі, що зловмисники використовують ШІ для створення біологічної зброї, смертоносність якої перевищує природні пандемії. Іншим прикладом є запуск шахрайського штучного інтелекту з наміром завдати великої шкоди.

Якщо система ШІ наділена достатнім інтелектом або можливостями, вона може спричинити хаос у суспільстві.

«Зловмисники можуть навмисно випустити шахрайський ШІ, який активно намагається завдати шкоди людству», — додав Хендрікс.

Проте це не лише короткострокова загроза, яка хвилює експертів. Оскільки штучний інтелект пронизує різні аспекти економіки, відмова від контролю над технологіями потенційно може призвести до довгострокових проблем.

Ця залежність від штучного інтелекту може зробити «їх вимкнення» руйнівним і ймовірно недосяжним. Отже, ризикуючи владою людства над своїм майбутнім.

Зловживання та його далекосяжні наслідки

Як попередив Сем Альтман, здатність ШІ створювати переконливі тексти, зображення та відео може призвести до значних проблем. Справді, він вважає, що «якщо ця технологія піде не так, вона може піти зовсім не так».

Візьмемо, наприклад, підроблене зображення потужного вибуху біля Пентагону, яке було поширене в соціальних мережах. Це призвело до тимчасового падіння на фондовому ринку, оскільки багато облікових записів у соціальних мережах, у тому числі кілька перевірених, поширили оманливу фотографію за лічені хвилини, посиливши безлад.

Таке зловживання ШІ вказує на потенціал технології для поширення дезінформації та порушення суспільної гармонії. Старший науковий співробітник Оксфордського інституту етики штучного інтелекту Елізабет Реньєріс стверджує, що штучний інтелект може «спричиняти експоненціальне збільшення обсягу та поширення дезінформації, тим самим руйнуючи реальність і підриваючи довіру громадськості».

Ще одна тривожна тенденція – поява «галюцинаторного» ШІ. Це тривожне явище, коли ШІ викидає помилкову, але, здавалося б, правдоподібну інформацію.

Ця вада, продемонстрована в нещодавньому інциденті з ChatGPT, може поставити під сумнів довіру до компаній, які використовують ШІ, і ще більше сприяти поширенню дезінформації.

Розмивання робочих місць і вибух нерівності

Швидке впровадження штучного інтелекту в різних галузях кидає тривожну тінь на ринок праці. З розвитком технологій потенційне звільнення мільйонів робочих місць стало гострою проблемою.

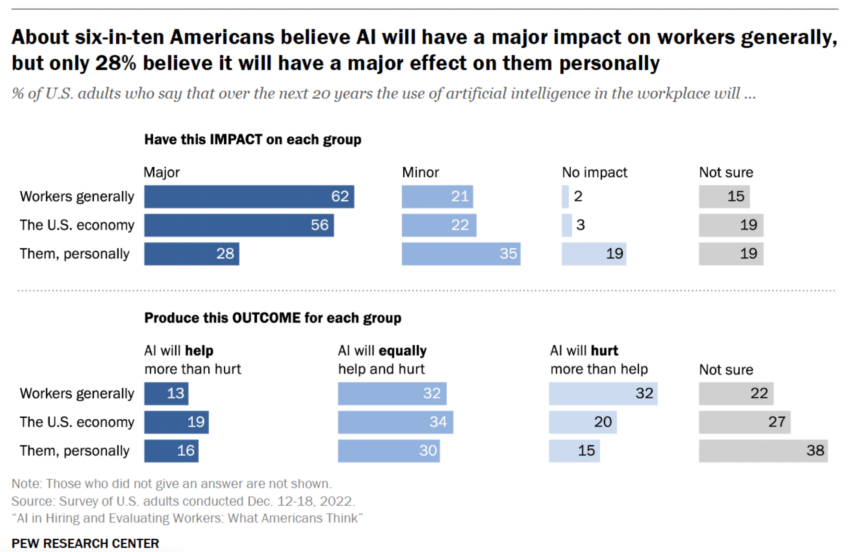

Недавній огляд виявили, що шість із десяти американців вважають, що використання ШІ на робочому місці суттєво вплине на працівників у наступні 20 років. Близько 28% респондентів вважають, що використання технології вплине на них особисто, а ще 15% вважають, що «ШІ зашкодить більше, ніж допоможе».

Сплеск автоматизованого прийняття рішень може сприяти зростанню упередженості, дискримінації та відчуження. Це також може сприяти створенню середовища нерівності, особливо вплинувши на тих, хто перебуває з іншого боку цифрового розриву.

Крім того, перехід до залежності від ШІ може призвести до «ослаблення» людства. Це може бути схоже на антиутопічний сценарій у таких фільмах Wall-E.

Центр безпеки штучного інтелекту зазначив, що домінування ШІ може поступово потрапити під контроль обмеженої кількості організацій. Це може дозволити «режимам нав’язувати вузькі цінності за допомогою повсюдного спостереження та жорсткої цензури».

Це похмуре бачення майбутнього підкреслює потенційні ризики, пов’язані з штучним інтелектом, і підкреслює необхідність суворого регулювання та контролю.

Заклик до регулювання ШІ

Серйозність цих занепокоєнь спонукала лідерів галузі виступати за посилення правил штучного інтелекту. Цей заклик до державного втручання перегукується зі зростаючим консенсусом щодо того, що розробкою та розгортанням штучного інтелекту слід ретельно керувати, щоб запобігти неправильному використанню та ненавмисному суспільному руйнуванню.

Залежно від того, як з ним поводитись, штучний інтелект може стати благом чи прокляттям. Вкрай важливо сприяти глобальній дискусії про пом’якшення ризиків, одночасно користуючись перевагами цієї потужної технології.

Прем’єр-міністр Великобританії Ріші Сунак стверджує, що штучний інтелект зіграв важливу роль у допомозі людям з паралічем ходити та розробці нових антибіотиків. Тим не менш, ми вкрай важливі, щоб ці процеси проводилися надійно та безпечно.

«Люди будуть стурбовані повідомленнями про те, що штучний інтелект створює ризики для існування, такі як пандемії чи ядерні війни. Я хочу, щоб вони були впевнені в тому, що уряд дуже уважно дивиться на це", - сказав Сунак.

Управління штучним інтелектом має стати глобальним пріоритетом, щоб він не став загрозою для існування людства. Щоб скористатися перевагами штучного інтелекту, одночасно зменшуючи ризики вимирання людства, важливо діяти обережно та пильно. Уряди також повинні приймати правила, сприяти глобальній співпраці та інвестувати в ретельні дослідження.

відмова

Дотримуючись вказівок Trust Project, ця тематична стаття представляє думки та точки зору експертів галузі або окремих осіб. BeInCrypto прагне прозорого звітування, але погляди, висловлені в цій статті, не обов’язково відображають погляди BeInCrypto або його співробітників. Читачі повинні перевірити інформацію самостійно та проконсультуватися з фахівцем, перш ніж приймати рішення на основі цього вмісту.

Джерело: https://beincrypto.com/artificial-intelligence-ai-risk-of-human-extinction/